RAG industrial: cuando las máquinas responden a preguntas

En este artículo se presenta una introducción a los fundamentos de la técnica RAG y su aplicación en la mejora de la precisión y relevancia de las respuestas generadas por modelos de lenguaje. Además, se describe un caso de uso desarrollado por el Grupo de Digitalización del Centro de Fabricación Avanzada Aeronáutica (CFAA), donde se aplica RAG para optimizar el acceso a la documentación técnica de una máquina de brochado externo, facilitando la consulta de información dispersa y mejorando la eficiencia en las operaciones de mantenimiento y soporte técnico.

En los últimos años, los chatbots y sistemas conversacionales han evolucionado rápidamente hasta convertirse en herramientas reales y útiles para empresas e industria. En concreto, entre 2022 y 2023, con la llegada de sistemas como ChatGPT o Llama, se produjo un cambio profundo en la forma en la que interactuamos con la información: podemos preguntar en lenguaje natural y obtener respuestas elaboradas en segundos, sin necesidad de navegar entre cientos de páginas web o informes técnicos.

El núcleo principal de estos sistemas son los modelos de lenguaje a gran escala (LLMs, del inglés Large Language Models), sistemas de inteligencia artificial entrenados con grandes volúmenes de texto para comprender, generar y razonar sobre lenguaje natural, permitiendo responder preguntas, redactar textos o asistir en tareas cognitivas complejas. A diferencia de los motores de búsqueda tradicionales, como Google, que se limitan a recuperar enlaces o documentos existentes en la web, un LLM no busca, genera. Ante una consulta, produce una respuesta palabra por palabra basándose en los patrones aprendidos durante su entrenamiento [1].

Desde su popularización, los LLMs han avanzado significativamente y ya no se limitan a responder preguntas simples: pueden interpretar documentos complejos y extensos, resumir documentación técnica, comparar datos o traducir instrucciones especializadas de forma comprensible y contextualizada. Sin embargo, estas capacidades presentan una limitación importante: los LLMs pueden “alucinar”, es decir, generar información incorrecta o ficticia cuando carecen de fuentes fiables. En otras palabras, inventan información plausible pero falsa, como si “rellenasen los huecos” de su conocimiento con suposiciones.

Para superar esa limitación, surge la técnica Retrieval-Augmented Generation (RAG), que combina la capacidad generativa de los LLMs con la recuperación de información externa y verificable. De esta manera, el modelo primero recupera documentos relevantes, y posteriormente, genera la respuesta a partir de ellos, reduciendo alucinaciones y mejorando la precisión con datos actualizados o específicos [2].

La adopción de RAG se ha extendido rápidamente a diversos sectores como el sanitario [3], financiero [4] o en el desarrollo de software (p. ej., GitHub Copilot), por su capacidad para combinar el razonamiento de los LLMs con el acceso a información fiable. En el ámbito industrial, esta tecnología resulta especialmente útil, ya que la documentación técnica de las máquinas de fabricación suele estar dispersa en múltiples fuentes (manuales impresos, documentos PDF o bases de datos internas) lo que dificulta su consulta o interpretación rápida. Mediante RAG, las empresas pueden unificar y contextualizar su conocimiento técnico, ofreciendo respuestas precisas a operarios o técnicos, mejorando la eficiencia y reduciendo tiempos de parada o errores de operación.

Fundamentos de RAG

La técnica RAG representa una evolución en el uso de modelos de lenguaje, al combinar su capacidad de generación coherente de texto con el acceso a fuentes de información externas y actualizadas. En esta sección se describen los principios básicos de su funcionamiento, la integración entre recuperación de información y generación de texto, y su relevancia para entornos industriales y técnicos.

Existen múltiples formas de implementar un sistema RAG, que varían según la tecnología empleada para la recuperación de información. Algunas aproximaciones utilizan bases de datos vectoriales, que permiten buscar documentos por similitud; otras emplean bases de datos de grafos, capaces de representar relaciones complejas entre entidades, e incluso existen arquitecturas híbridas que combinan ambas. Sin embargo, todas las variantes de RAG comparten dos fases fundamentales:

- Recuperación de información (consulta/búsqueda semántica, llamada Retrieval), en la que se localizan los fragmentos de información más relevantes.

- Generación (Generation) de la respuesta, donde el LLM integra esos fragmentos recuperados con la consulta original y redacta una respuesta coherente y contextualizada.

En este trabajo, se ha optado por utilizar bases de datos vectoriales como núcleo del sistema RAG, debido a su eficiencia en búsquedas semánticas y su buena integración con los modelos de lenguaje actuales. Este enfoque permite representar cada documento técnico mediante vectores numéricos que capturan su significado, facilitando la recuperación de información relevante incluso cuando las consultas no coinciden literalmente con el texto original.

La construcción de un sistema RAG basado en bases de datos vectoriales implica una serie de pasos clave, que combinan el diseño de sistemas software con el uso de modelos de lenguaje:

- Selección del LLM y del sistema gestor de bases de datos vectorial, considerando factores como el tamaño del modelo, los recursos computacionales disponibles y la capacidad de búsqueda semántica del motor elegido.

- Recopilación y procesamiento de la documentación técnica, procedente de manuales técnicos, páginas web, esquemas o informes en PDF, para generar sus representaciones vectoriales y almacenarlas en el sistema gestor para su posterior consulta.

- Implementación de un framework de orquestación, que actúa como puente entre el LLM y la base de datos vectorial, gestionando las consultas, la recuperación de información relevante y la generación final de las respuestas.

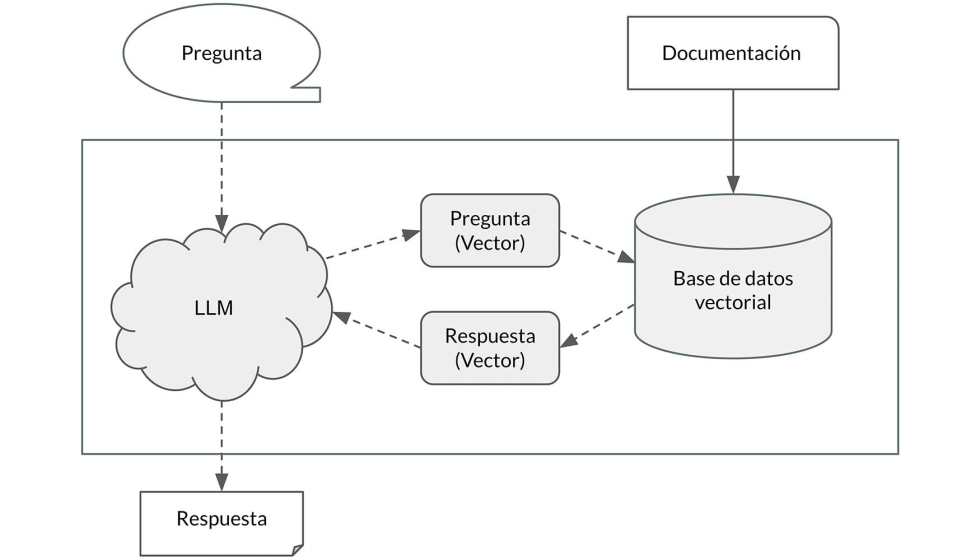

El flujo general de funcionamiento se muestra en la figura 1.

Figura 1. Flujo básico de la arquitectura RAG.

- La consulta del usuario es recibida por el LLM, que la convierte en un vector numérico que representa su significado semántico.

- Ese vector se utiliza para buscar en la base de datos vectorial los fragmentos de información más similares, mediante una comparación por proximidad en el espacio vectorial (fase Retrieval).

- Una vez recuperados los resultados más relevantes, el LLM los integra con la consulta original y genera una respuesta en lenguaje natural, combinando su capacidad de redacción con la información específica obtenida de la base de datos (fase Generation).

El uso de RAG presenta numerosas ventajas frente a los enfoques tradicionales basados exclusivamente en modelos de lenguaje. La más relevante es la reducción significativa de las alucinaciones, ya que el modelo no depende solo de lo que aprendió durante su entrenamiento, sino que se apoya en información real y actualizada procedente de fuentes externas.

Además, elimina la necesidad de reentrenar o ajustar un LLM con documentación específica, un proceso que suele ser muy costoso en términos de tiempo, datos y recursos computacionales. Entrenar o afinar un modelo requiere disponer de grandes volúmenes de texto limpio y estructurado, así como de infraestructura de cómputo especializada (generalmente GPUs de alto rendimiento). En lugar de ello, basta con recopiar y vectorizar la documentación existente, lo que permite ajustar, actualizar o ampliar el conocimiento del sistema de forma rápida y económica, sin modificar el modelo base.

Caso de uso en el CFAA

En el CFAA se investigan, validan e industrializan tecnologías de fabricación avanzada orientadas al sector aeronáutico, con especial atención al mecanizado de alta precisión, la automatización y control, la metrología dimensional, la integración digital de procesos y la ingeniería de materiales y superficies, entre otras áreas. Esta orientación permite abordar proyectos con madurez cercana a planta —desde la definición del proceso hasta su verificación en condiciones representativas de producción— y transferir resultados de forma ágil al tejido industrial.

En particular, para el proceso de brochado, un mecanizado por arranque de viruta que utiliza una brocha multidentada para generar perfiles internos o externos (ranuras, estriados, formas poligonales) en una sola pasada, con alta repetibilidad y tolerancias estrechas, el centro dispone de un área específica de brochado. En ella se integra una brochadora electromecánica EKIN A218 (figura 2) como banco de ensayos preindustrial, destinada a la definición de parámetros de proceso, la validación de herramientas y la estandarización de procedimientos de operación y mantenimiento. Esta instalación es, además, el caso de uso donde se ha desplegado el sistema RAG industrial, facilitando el acceso inmediato y contextualizado a la documentación técnica (manuales, alarmas, calibraciones y ajustes) y reduciendo tiempos de consulta y riesgo de error operativo.

En su operación diaria, los operarios y técnicos deben consultar con frecuencia manuales técnicos o guías de mantenimiento para resolver dudas sobre alarmas, ajustes o calibraciones. Dicha información suele estar dispersa en múltiples fuentes, dificultando su acceso, y provocando demoras en la toma de decisiones. El sistema RAG permite a los operarios formular preguntas en lenguaje natural y obtener respuestas precisas basadas en los manuales oficiales del fabricante.

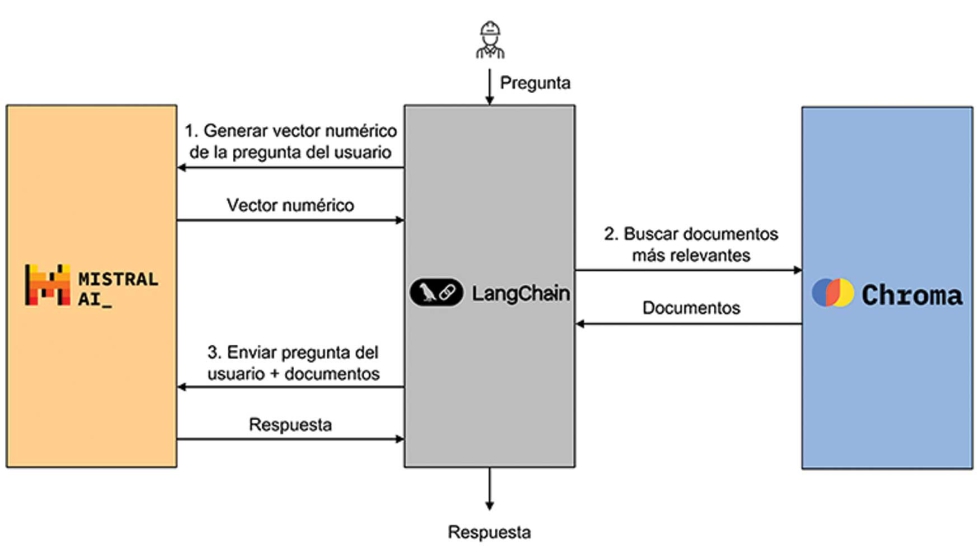

El sistema RAG se ha implementado con los siguientes módulos software, cuya interacción se ha representado en la figura 3:

- Chroma: sistema gestor de bases de datos vectoriales, elegido por su simplicidad, eficiencia en búsquedas semánticas y compatibilidad con múltiples formatos.

- Mistral: modelo de lenguaje ligero, de alto rendimiento y código abierto, capaz de ofrecer respuestas precisas con un consumo computacional reducido.

- LangChain: framework de integración, elegido por su amplio ecosistema, flexibilidad y madurez en la integración de LLMs con fuentes de datos externas.

La documentación técnica utilizada para poblar la base de datos ha sido la proporcionada por EKIN, fabricante de la brochadora. Se procesaron 1096 páginas de manuales de operación, funcionamiento y control numérico. Como muestra del formato de esta documentación, las figuras 4 y 5 muestran, respectivamente, una página predominantemente textual y otra con contenido mixto (texto e imágenes).

La vectorización de esta documentación no fue un proceso automático de un sólo paso, si no que requirió diferentes decisiones. Una de ellas fue la fragmentación, la cantidad de texto que se desea condensar en cada vector individual. El tamaño de cada fragmento se ajustó cuidadosamente, ya que fragmentos demasiado extensos podrían perder detalles importantes y quedarse con información demasiado general (precisión semántica), mientras que los excesivamente cortos carecen de contexto suficiente y no incluirían suficiente información como para ser útiles. Se optó por una segmentación basada en las secciones originales del manual. Después, si algún fragmento era demasiado largo, se dividía en fragmentos más cortos, manteniendo así el contexto y obteniendo varios fragmentos por sección.

Otro aspecto importante en la vectorización fue el tratamiento de las imágenes. Diagramas como el mostrado en la Figura 5 son fuente relevante de información técnica, que se deben incluir en la base de datos. Previo a la vectorización del texto, las imágenes y diagramas se procesaron mediante el modelo multimodal Qwen3, capaz de generar descripciones textuales a partir de contenido visual.

Con las descripciones de las imágenes y el tamaño de fragmentación decidido, todo el texto de la documentación se convirtió en vectores utilizando el modelo mistral-embed, un modelo desarrollado por Mistral enfocado a la transformación de texto. Como parte de esta vectorización, cada fragmento de texto se unió a sus metadatos (manual, sección y número de página) correspondientes. Así, cuando un usuario formula una consulta, esta se transforma en un vector y se compara con los existentes, extrayendo los fragmentos más relevantes para generar la respuesta final.

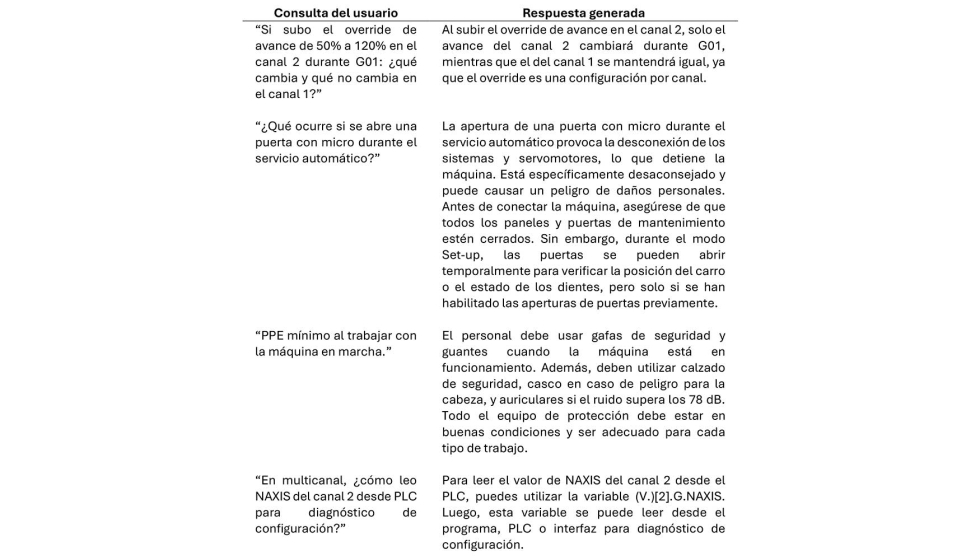

El resultado final es un sistema que permite realizar preguntas sobre la documentación de la brochadora EKIN A218. En la siguiente tabla se incluyen algunas preguntas de ejemplo y las respuestas proporcionadas por el sistema:

Conclusiones y trabajo futuro

La implementación de un sistema RAG en el entorno de CFAA representa un avance significativo en la digitalización del conocimiento técnico en planta. Al integrar modelos de lenguaje con bases de datos vectoriales locales, se ha logrado reducir la dependencia de búsquedas manuales en documentación dispersa, mejorando la eficiencia operativa y disminuyendo el riesgo de errores humanos.

Esta solución demuestra que las tecnologías de IA generativa pueden adaptarse con éxito a entornos industriales exigentes, siempre que se diseñen con criterios de robustez, privacidad y utilidad práctica. Además, se considera que favorece la transferencia tecnológica, porque conecta de forma práctica el conocimiento del fabricante con las necesidades del operario en planta, acelerando la adopción de buenas prácticas y estandarizando procedimientos.

Sobre este trabajo, una de las líneas futuras es extender el sistema más allá de la consulta de manuales, permitiendo la conexión a datos en tiempo real procedentes de sensores, cámaras o sistemas de control. Una forma de implementar esta característica es mediante el uso de Model Context Protocol (MCP), un protocolo moderno que permite la conexión de un sistema RAG a fuentes de datos en línea.

Otra línea de investigación consiste en extraer los conceptos principales de la documentación y relacionarlos en un grafo de conocimiento, en vez de crear vectores numéricos. Los grafos de conocimiento son estructuras de nodos y relaciones, cuyas entidades son anotadas mediante vocabularios estandarizados (Ontologías), permitiendo así el razonamiento automático y una mayor expresividad semántica con respecto a las representaciones vectoriales. Este enfoque podría mejorar la precisión semántica, al capturar de manera explícita las relaciones entre conceptos técnicos.

Finalmente, la incorporación de agentes inteligentes será un paso clave en esta evolución. Estos agentes, que combinan modelos de lenguaje con capacidades de razonamiento y ejecución, podrán tomar decisiones, realizar tareas o interactuar con otras herramientas del sistema de manera autónoma. En un entorno industrial, podrían consultar información del RAG, analizar datos del proceso y proponer ajustes operativos, cerrando el ciclo entre la documentación, la monitorización en tiempo real y la acción sobre la máquina.

Referencias

[1] Humza Naveed et al. 2025. A Comprehensive Overview of Large Language Models. ACM Trans. Intell. Syst. Technol. 16, 5, Article 106 (October 2025), 72 pages. https://doi.org/10.1145/3744746

[2] Wenqi Fan et al. 2024. A Survey on RAG Meeting LLMs: Towards Retrieval-Augmented Large Language Models. In Proceedings of the 30th ACM SIGKDD Conference on Knowledge Discovery and Data Mining (KDD '24). Association for Computing Machinery, New York, NY, USA, 6491–6501. https://doi.org/10.1145/3637528.3671470

[3] Yang, R., Ning, Y., Keppo, E., Liu, M., Hong, C., Bitterman, D. S., ... & Liu, N. (2025). Retrieval-augmented generation for generative artificial intelligence in health care. npj Health Systems, 2(1), 2.

[4] Gondhalekar, C., Patel, U., & Yeh, F. C. (2025). MultiFinRAG: An Optimized Multimodal Retrieval-Augmented Generation (RAG) Framework for Financial Question Answering. arXiv preprint arXiv:2506.20821.

Este trabajo ha sido parcialmente financiado por el Gobierno Vasco a través del proyecto XWAVE (código KK2025/00056). También queremos agradecer el apoyo proporcionado por el aula AIMS (Artificial Intelligent Manufacturing for Sustainability) de la Universidad del País Vasco, así como la financiación del grupo de investigación universitario (IT1573-22), concedida por el Gobierno Vasco.

Nahia Iturregi Artiñano, investigadora en el CFAA

Estudiante del Grado en Ingeniería Informática de Gestión y Sistemas de Información en la EHU. Su trabajo se centra en el ámbito de la inteligencia artificial, especialmente en el uso de modelos de lenguaje y técnicas de recuperación aumentada de información, mostrando un interés general por la computación avanzada y el desarrollo de soluciones innovadoras aplicadas a la industria y la tecnología.

Endika Tapia Fernández, investigador del CFAA

Ingeniero informático en Gestión y Sistemas de Información en la EHU. Su área principal de investigación es la computación paralela y distribuida, con especial atención a computación de alto rendimiento, sistemas de procesamiento de datos escalables y protocolos de comunicación industrial y conectividad.

Mikel Egaña Aranguren, profesor agregado en el departamento de Lenguajes y Sistemas Informáticos (LSI) de la EHU.

Sus intereses de investigación giran en torno a la idea de publicar y consumir datos de forma interoperable: por ejemplo, siguiendo los principios FAIR (Localizables, Accesibles, Interoperables, Reutilizables). También trabaja en Datos Abiertos, la transparencia gubernamental, los Grafos de Conocimiento, la aplicación de los LLM (por ejemplo, mediante GraphRAG y en última instancia los Agentes), los Datos Enlazados, la Web Semántica, el Software Libre, la ingeniería de ontologías, la bioinformática, la informática médica y las lenguas minorizadas o de bajos recursos como el euskera.

Unai López Novoa, profesor agregado en el departamento de Lenguajes y Sistemas Informáticos (LSI) de la EHU.

Imparte docencia en el Grado en Ingeniería Informática de Gestión y Sistemas de Información en la Escuela de Ingeniería de Bilbao. Su área principal de investigación es la computación paralela y distribuida, con especial interés en sistemas de datos escalables y eficiencia energética.

Leonardo Sastoque Pinilla, investigador doctor del CFAA, coordinador de proyectos de I+D y digitalización industrial.

Su trabajo combina gestión de proyectos y transferencia tecnológica (TRL 5–7) con fabricación avanzada. En los últimos años ha publicado sobre monitorización y eficiencia energética en máquina-herramienta y sobre brochado de Inconel 718, aplicando técnicas de IA/ML en entornos industriales.