Historia, bondades y riesgos de la Analítica de Datos

Carlos Pascual Adell, socio fundador y director de Singular Beacon, SL

03/05/2022¿Qué es la Ciencia de Datos?

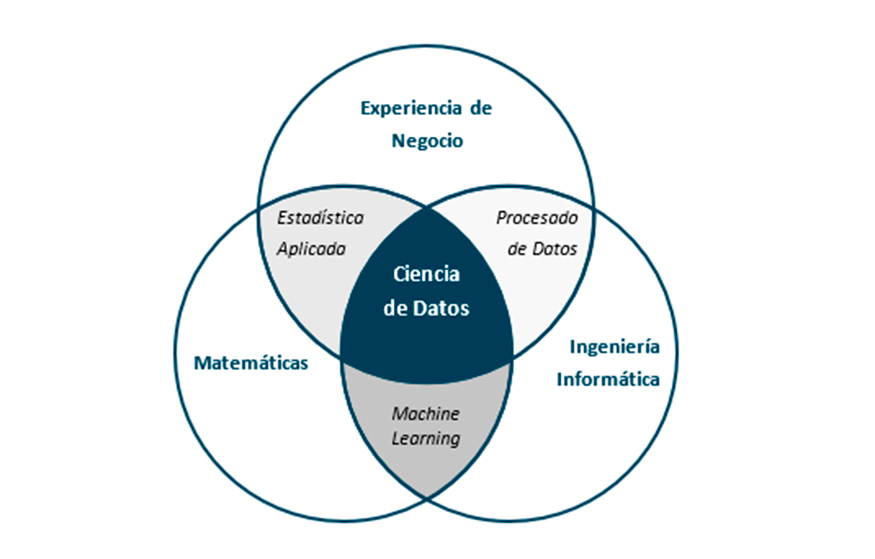

Se trata de una disciplina que permite tomar decisiones informadas y soportadas en evidencias científicas combinando: Experiencia de negocio, para detectar necesidades y definir casos de uso; Conocimientos matemáticos, para dar respuestas fundamentadas; e Ingeniería Informática, para escalar los cálculos y realizarlos de forma optimizada.

¿Cómo es el proceso analítico?

Como hemos dicho, todo empieza por tener datos primando siempre calidad frente al volumen. Una vez que tenemos esos datos, gracias a la matemática y la estadística, podemos analizar tendencias y relaciones entre los mismos para extrapolar conclusiones. En términos sencillos, buscar patrones que se repiten entre ellos.

Una vez hecho este análisis, seremos capaces, mediante otras técnicas, de algo que solo los ordenadores nos permiten hoy en día, crear modelos. Un modelo es una representación / simulación de la realidad en la que entran unos datos y salen otros. Estos modelos pueden ser de diversa índole, pero en términos generales hablamos de: predicciones, clasificaciones o recomendaciones.

Por hacerlo más claro, ya desde hace años un experto en una materia mediante observación y registro sencillo de datos, muchas veces en papel, era capaz de acertar con una precisión impecable una determinada avería. Un ejemplo claro lo tenéis en un mecánico de un coche. Esto es gracias a que el cerebro humano también analiza lo que ve y busca patrones y es capaz de inferir relaciones de correlación y/o causalidad. Note el lector más atento que correlación no implica causalidad.

Lo que la Ciencia de Datos nos ha brindado es hacerlo: de una forma más precisa, manejando muchos más datos, evaluando muchos más patrones sin olvidar nada y no siendo dependiente del experto.

Una vez cargado el modelo en un ordenador, podemos automatizar el proceso de análisis y la obtención de resultados. Todo ello para cualquier proceso que podamos imaginar. Es posible dar otro paso más, tratando de acercar la inteligencia artificial al modo en que los humanos tomamos decisiones.

Dicho de otra forma, este modelo puede evolucionar a medida que trabaja, lee datos, produce una salida y se alimenta de los resultados reales auto ajustándose (aprendiendo) sobre la marcha. Esto es parte de lo que se denomina aprendizaje de las maquinas o 'Machine Learning' y su desarrollo y generalización ha sido posible gracias a la disponibilidad de grandes cantidades de datos, el abaratamiento de los costes, el incremento de la capacidad de procesado y la generalización del acceso a las técnicas y algoritmos

¿Qué tipos de problemas trata la Ciencia de Datos?

La analítica de datos, por orden de madurez, puede dar respuestas a diferentes preguntas:

- Entender el pasado: ¿qué pasó?, ¿por qué?, ¿con qué frecuencia?, ¿dónde?

- Actuar de forma ágil en el presente: ¿qué está pasando ahora? ¿qué factores lo están motivando?

- Predecir el futuro: ¿qué pasará si estas tendencias continúan?

- Cambiar el futuro: ¿cuál es la mejor forma de…? ¿qué debemos hacer para…?

Estas preguntas se pueden agrupar en tres tipos de problemas: Los problemas de segmentación/clasificación que tienen como objetivo dividir los elementos de un conjunto en base a atributos que los hacen diferentes. Problemas de predicción que se centran en extrapolar un comportamiento futuro a partir de un comportamiento presente y problemas de optimización que tratan de encontrar la mejor estrategia para resolver un problema.

A su vez, estos problemas pueden resolverse mediante los siguientes tipos de algoritmos: algoritmos supervisados: donde es necesaria una intervención manual o etiquetado de los datos, por ejemplo, darle al modelo ejemplos de aquello que quiere clasificar. Algoritmos no supervisados que se basan exclusivamente en características extraídas de los datos y algoritmos de aprendizaje reforzado basados en algoritmos no supervisados que mejora a partir del 'feedback' que reciben.

¿Cómo ha evolucionado la Ciencia de Datos?

Tras la II Guerra Mundial el taylorismo se adopta de manera generalizada a la par que los ordenadores se investigan extensamente. En 1962 John W. Tukey estadístico y considerado el padre de la Ciencia de Datos se cuestiona el futuro de la estadística como ciencia empírica. A principios de los 70 Peter Drucker, consultor de negocio, introduce el término 'Trabajador del conocimiento' y en paralelo Peter Naur acuño el término que utilizamos actualmente como Data Science (Ciencia de Datos).

Ya para los 80 el uso de Microsoft Excel se generaliza como la herramienta base de los Trabajadores del conocimiento y a finales de los 90 internet conecta el mundo y pone a disposición de todos el acceso al conocimiento. Este primer internet también se conoce como internet 1.0 o del contenido. Seguidamente, en los 2000, surge el boom de las DOTCom. Todas las empresas ponen su negocio online. Se empieza a gestar el internet 2.0 o de los servicios (tiendas online, acceso a plataformas web, contratación de servicios). Por aquel entonces -principios de los 2000- William S. Cleveland, informático y estadístico, introduce la Ciencia de Datos como una disciplina unificada e independiente.

Desde el 2005 en adelante las empresas de servicios comienzan a transformar la experiencia de usuario basada en datos y analítica. Las redes sociales toman peso y surge lo que conocemos como el internet 3.0 o de las personas donde lo que prima es estar conectados. El uso extensivo y generalizado de los smartphones da lugar al comienzo de la era de economía bajo demanda, surgen empresas como Uber, Airbnb, Amazon, Netflix (vertical de streaming) entre otras. Los dispositivos que utilizamos en el día a día como electrodomésticos y coches están cada vez más interconectados en lo que se ha denominado el internet 4.0 o de las cosas (IoT o Internet of Things).

La previsión es que se extienda el uso de Machine Learning e Inteligencia Artificial a cada vez más ámbitos gracias a la tecnificación de usuarios y especialistas; y la generalización, aumento y abaratamiento de la capacidad de cálculo.

¿Qué hay de verdad en la Ciencia de Datos?

Este es uno de los casos donde la realidad supera a la ficción. La Ciencia de Datos tiene una particularidad que explica su crecimiento y es que es una disciplina muy accesible, pues el conocimiento y la tecnología están disponibles de forma generalizada y a muy bajo coste.

Hace unos meses comentaba Enrique Tellado en una mesa redonda algo, a priori, utópico: la posibilidad de vivir en una sociedad donde, gracias a la tecnología, el trabajo tal y como lo entendemos en jornadas de 8 horas diarias, no fuera necesario. Dejando a un lado los matices políticos, esta es una utopía que podríamos ver materializada a finales de este siglo. Esto por no hablar por los avances en el mundo médico y en otras disciplinas. Como defiende Steven Pinker en su obra 'Los Ángeles que Llevamos Dentro', el progreso como sociedad es innegable, cada vez vivimos mejor. En esto la tecnología, la ciencia de datos y la inteligencia artificial están jugando un papel clave.

Carlos Pascual Adell, socio fundador y director de Singular Beacon.

¿Se puede predecir cualquier cosa?

La respuesta clara es que no, si así fuera, no existirían los casinos ni la lotería. Existen fenómenos que, por su naturaleza, no son predecibles, aunque a priori sean deterministas. Un sistema determinista es aquel en el cual podemos conocer su estado actual en base a las condiciones iniciales y, por tanto, predecir que va a pasar. Justo lo contrario de lo que es un 'Proceso Estocástico' que es aquel cuyo comportamiento no es determinista, en la medida en la que el subsiguiente estado del sistema se determina, tanto por las acciones predecibles del proceso, como por elementos aleatorios. Aquí también juega un papel importante lo que se conoce como 'Teoría del Caos', que se centra en sistemas deterministas muy sensibles a variaciones.

En cualquier caso, sí podemos, y de hecho predecimos muchas cosas. La clave está en que la calidad de los datos sea suficientemente extensa y buena.

Por extensa nos referimos a significativa y por significativa nos referimos a que se tengan en cuenta suficientes sucesos para extrapolar una conclusión. Esto se conoce como significancia y tiene que ver con la probabilidad de que la hipótesis contraria o nula sea cierta. Un ejemplo sería si preguntamos a dos personas que van a votar en las elecciones y los dos coinciden. Podríamos decir que, un determinado partido político, tiene un 100% de probabilidad de ganar en base a que las dos personas coinciden. Si una tercera opina y discrepa, entonces la probabilidad de que ese partido gane baja notablemente a un 66%. Si en vez de dos personas pregunto a 1.000, el hecho de preguntar a una más tendrá menor impacto en la estimación de intención de voto. Esto tiene que ver con teoría del muestreo y es la base de los sondeos políticos, entre otras cosas, pero, para el caso que nos ocupa, nos sirve para explicar dos ideas: (1) con pocos datos es difícil extrapolar conclusiones con confianza y (2) no hace falta preguntar a toda la población, sino a una muestra representativa y aleatoria, para poder hacer una estimación significativa.

Por buena o representativa nos referimos a que sean fiel a la realidad, no exista sesgo y los datos sean precisos y coherentes con la naturaleza del fenómeno. Un buen ejemplo de ello es la pregunta que hicieron a Abraham Wald, doctor en matemáticas, en el Centro de Análisis Naval en Plena II Guerra Mundial. La pregunta, resumida, decía así: Dado este plano que representa donde han recibido más impactos los aviones que regresan de los combates, ¿Dónde consideras que deberíamos poner mayor refuerzo de blindaje? Este es el ejemplo más común que se utiliza para explicar el concepto de 'Sesgo de Supervivencia' y la respuesta es: Donde no haya balas porque eso indica que son las zonas más críticas y sensibles del avión, y la razón de que no aparezcan en los planos, es que han sido derribados y no han podido analizarse posteriormente.

¿Nos encontramos ante un fenómeno que puede mejorar el progreso y el bienestar de la humanidad?

Rotundamente si, la detección de tumores en radiodiagnóstico mediante visión artificial (redes neuronales) es un ejemplo excelente. El registro de nuestros datos médicos, junto a análisis genéticos, nos ayudaran a predecir mejor posibles enfermedades. Nuestras fábricas, mediante un mantenimiento predictivo basado en el seguimiento del ciclo de vida de sus componentes, serán más eficaces y seguras.

Estos avances los podemos disfrutar ya en el día a día, por ejemplo, nuestros vehículos, que mantienen un registro de lo que sucede durante su vida útil, pueden avisarnos de posibles fallos de eficiencia y sugerir el mantenimiento más adecuado. Hace ya mucho tiempo, esta ciencia se basó en los aplicativos utilizados en la industria aeronáutica y nuclear, para hacer análisis probabilístico. Estos avances podemos verlos hoy en las turbinas de los aviones comerciales que, en tiempo real, envían datos a los fabricantes para poder mejorar sus modelos de comportamiento.

Hoy en día las empresas recogen datos de todos nosotros… ¿cómo sabemos que no se utilizaran con malos fines?

Lo oportuno aquí sería discernir entre malos fines desde un punto de vista legal o ético. El caso de Cambridge Analítica en las elecciones americanas del 2016, es un buen ejemplo de uso ilícito. El equipo de Marketing de la campaña de Trump contrató a la empresa Cambridge Analítica para darle apoyo con la campaña. Esta obtuvo datos de un test de personalidad implementado en formato aplicación en Facebook que les permitió inferir perfiles psicológicos de los participantes. Gracias a esto desarrollaron noticias falsas que luego replicaron a través de redes sociales, blogs y medios. De esta forma determinaron, entre otras cosas curiosas, que series como The Walking Dead, interesan a personas que se preocupan por la inmigración y adaptaron la publicidad para este segmento en base a ese interés.

Otro ejemplo que, sin ser ilícito, pudiera ser poco ético, es el que se conoce como Scroll Infinito de Instagram. La popular red tiene un algoritmo de recomendación muy sólido que es capaz de entender tus gustos en base a como interactúas con las publicaciones y mostrarte contenido relacionado con tus “intereses”, entendiendo interés, por aquello que te llama la atención. Si por ejemplo sueles detenerte o interactuar con publicaciones de Formula 1, te mostrará contenido relacionado con el mundo del motor que ha generado mucho 'engagement' (interés) entre los usuarios de la red. El resultado es que, cuando has terminado de ver las actualizaciones de tus contactos, el algoritmo te mostrará este tipo de contenido intercalado con publicidad.

El hecho de que el 'scroll' sea infinito incrementa el tiempo de uso del dispositivo. Esto aumenta la exposición a anuncios que es la fuente principal de monetización de la plataforma. La pregunta entonces es: ¿en qué medida consumir este contenido aporta valor? Y ¿debiera existir algún límite? Esto está explicado de forma excelente en el documental The Social Dilemma. En resumen y citando a Stan Lee: Un gran poder debe conllevar una gran responsabilidad

¿Cómo puede ser en el futuro nuestra interacción con las maquinas…aprenderán de los datos históricos y evolucionarán esos modelos…podrán pensar y evolucionar por sí mismas?

Tomando prestado el análisis realizado en el podcast de Orbita Laika en su episodio ¿Deberíamos temer a la Inteligencia Artificial?, podemos decir que, sin duda, las máquinas nos seguirán superando en cada vez más áreas. En 20 años y según un informe de la Casa Blanca, la inteligencia artificial habrá superado a la humana. Esto sin mencionar lo que se conoce como Singularidad Tecnológica, un punto donde las máquinas, capaces de evolucionar por sí mismas, puedan construirse y mejorarse sin ayuda del ser humano.

Ante la pregunta: ¿debemos temerla?, la respuesta sería: más que temerla, respetarla. Los más temerosos podéis alimentar vuestra curiosidad con dos ejemplos: el caso del Chatbot TAY desarrollado por Microsoft en 2016 que, en apenas 16 horas, se volvió racista y misógino; o los avances en computación cuántica y como se va a quedar obsoleto todo el sistema criptográfico actual. Lo que no está todavía claro es si las máquinas van a ser capaces de experimentar sentimientos pudiendo ser, esta, la última frontera entre la inteligencia humana y la artificial.