AgriScout: Un sistema de inspección de cultivos

Este documento presenta los aspectos más relevantes de un sistema de inspección de cultivos integrado en un vehículo eléctrico capaz de recorrer 80 km sin recarga. El vehículo está preparado para cubrir de manera autónoma un campo siguiendo un plan de ruta predefinido. En el vehículo se ha integrado, entre otros, un sensor RGB-D conectado a una computadora de alto rendimiento. La información heterogénea adquirida con el sensor RGB-D se integra posteriormente para generar automáticamente mapas en 3D de los cultivos mediante el uso de un software desarrollado por el grupo. El rendimiento del sistema de inspección se ha comprobado principalmente en viñedos. Los resultados muestran que la tecnología propuesta es viable y puede proporcionar información complementaria a otras alternativas de inspección.

Una de las etapas clave de un sistema de Manejo Integrado de Plagas (MIP) es el monitoreo o la inspección continua de los cultivos para garantizar que los problemas se detecten a tiempo. Mientras que en campos pequeños los operadores pueden realizar de forma efectiva esta vigilancia, en grandes extensiones la única opción viable es el muestreo discreto, seleccionando aleatoriamente o de forma regular un conjunto de puntos de muestreo. Así, el desarrollo de tecnologías que permitan la inspección automática y continua de un cultivo resulta de gran interés. Entre los diversos medios para recopilar información bien estructurada, los vehículos autónomos equipados con sensores son una tecnología prometedora a medio plazo para la adquisición de información en el campo. Pero el uso de robots móviles en entornos agrícolas sigue siendo un reto, ya que la navegación presenta dificultades debido a la variabilidad y la naturaleza tanto del terreno como de la vegetación. En Bechar y Vigneault (2016) se puede encontrar una revisión actual de los desarrollos e innovaciones en robots agrícolas para operaciones de campo y se analizan las limitaciones principales.

El uso de robots de tamaño mediano para inspeccionar completamente un cultivo utilizando un conjunto de sensores embarcados es una opción adecuada para minimizar la compactación del suelo y es el mejor medio de lograr una navegación segura en cultivos leñosos. Así, este tipo de robots puede ser una opción útil para la detección temprana de plagas recopilando la información georreferenciada necesaria para construir mapas precisos del cultivo. Es más, en casos como el de los cultivos leñosos, es posible realizar más de un muestreo durante el año gracias al mínimo impacto que tiene el vehículo.

En las siguientes secciones, se presenta un sistema de inspección y sus resultados de rendimiento iniciales. El sistema de inspección desarrollado está compuesto por: 1) una plataforma de inspección multisensorial y autónoma integrada en un vehículo comercial capaz de cubrir completamente un campo siguiendo una ruta predefinida (Conesa-Muñoz et al., 2016) y capaz de recopilar información georreferenciada; y 2) el software de desarrollo propio que permite generar automáticamente, a partir de la información heterogénea adquirida en el campo, un mapa tridimensional de las líneas de cultivo, así como el mapa de la distribución del volumen.

La plataforma de inspección

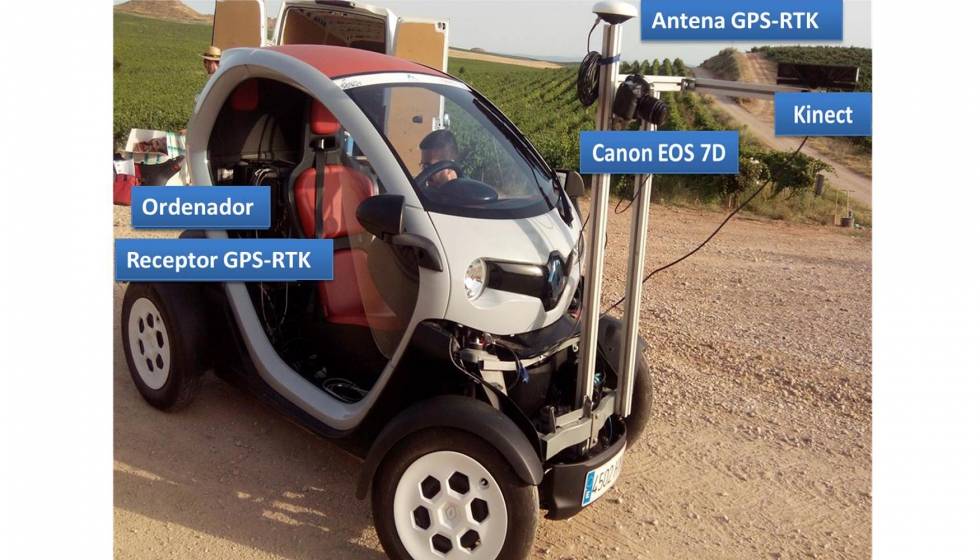

La plataforma de campo (Figura 1) se basa en un vehículo eléctrico Twizy (Renault) que tiene una autonomía de aproximadamente 80 km, con una carga de 3 horas y media con un enchufe estándar, y capaz de alcanzar una velocidad de 80 km/h. El vehículo, con una longitud de 2,32 metros, una anchura de 1,19 metros y una altura de 1,46 metros, permite velocidades libres de vibraciones por debajo de 3 km/h, lo que favorece la adquisición de información de gran calidad.

Se ha integrado una estructura de soporte de aluminio para colocar fácilmente los sensores adaptándolos a las características de cada tipo de muestreo. El sensor RGB-D (Kinect v2, Microsoft) integrado, y que es la base de la información que se presenta en este artículo, suministra 30 fotogramas por segundo; en pocas palabras imágenes RGB con una resolución de 1920 × 1080 píxeles junto con información de profundidad con una resolución de 512 × 424 píxeles. Los datos de profundidad se obtienen utilizando la tecnología ToF (tiempo de vuelo). La cámara está conectada al ordenador de a bordo que integra un procesador Intel Core i7-4771@3.5GHz, 16 GB de RAM y una tarjeta gráfica NVIDIA GeForce GTX 660. El vehículo de inspección está equipado además con un receptor RTK-GPS (R220, Hemisphere), que proporciona datos de ubicación a una frecuencia de muestreo de 20 Hz con un error de posición inferior a 2 cm.

Módulo de generación de mapas 3D

Por lo general, las dimensiones de los árboles se miden a mano en el campo, un trabajo realmente tedioso, y el volumen se estima aproximando la copa a un cuerpo geométrico regular o aplicando algún modelo empírico.

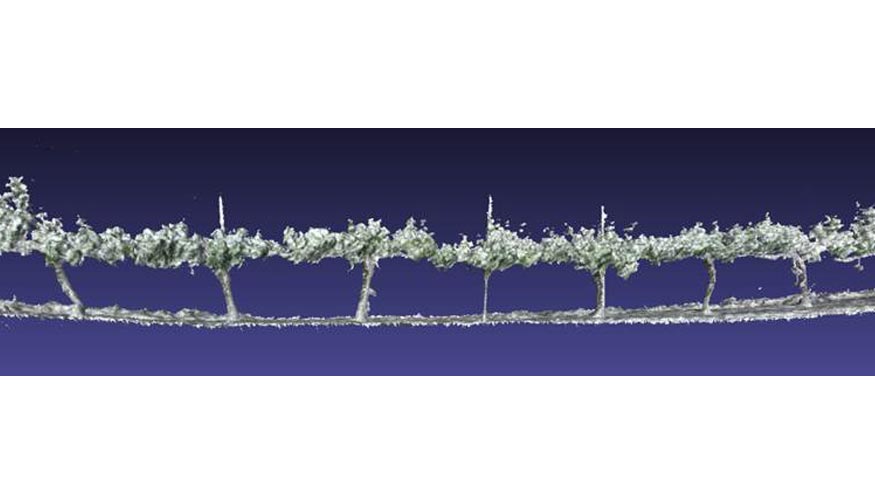

El proceso de generación de mapas 3D desarrollado es completamente automático y calcula las dimensiones como la altura, la anchura o el volumen a partir de una nube de puntos generada mediante la fusión de diferentes imágenes de profundidad superpuestas utilizando un método basado en el algoritmo descrito en (Niessner et al., 2013). El algoritmo, seleccionado por sus buenos resultados en la generación de nubes de puntos de grandes áreas, supera los problemas de otros métodos incluido el software de Microsoft (Newcombe, 2011), que solo gestiona volúmenes de hasta 8 metros cúbicos, lo que impone una restricción importante para los contextos agrícolas. Además, se ha integrado una variante del algoritmo Iterative Closest Point (ICP) (Chen y Medioni, 1992) para mejorar la precisión de la nube de puntos obtenida eliminando pequeñas derivas, así como se ha desarrollado un algoritmo (Bengochea-Guevara et al, 2017) para eliminar las grandes derivas que aparecen en líneas de más de 50 metros de longitud. La información de profundidad se fusiona con el modelo actual utilizando un promedio móvil ponderado, mientras que la información RGB también se actualiza utilizando un promedio móvil exponencial.

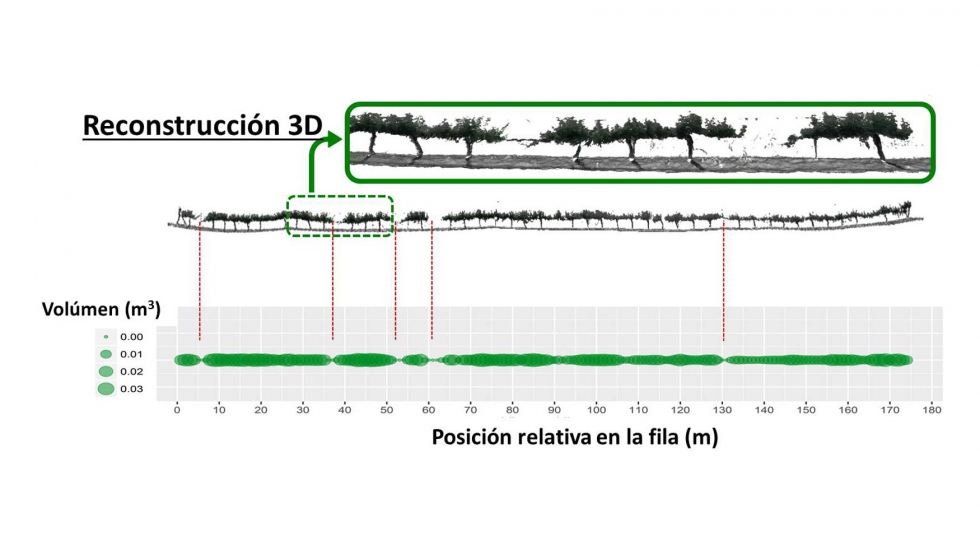

La Figura 4 muestra la reconstrucción de una de las hileras de viñedos muestreadas durante la campaña de febrero, así como la distribución de los volúmenes estimados para la hilera. Los valores de reconstrucción y volumen se obtuvieron a partir de los datos adquiridos al escanear solo un lado de la hilera de viñedos. Por lo tanto, los valores de volumen pueden subestimarse, aunque en cultivos leñosos con filas estrechas, como en este caso, es de suponer que la correlación entre el volumen estimado y el volumen real es alta. Además, la reconstrucción 3D y la distribución de volumen parecen coincidir consistentemente; por ejemplo, aparecen valores de volumen más bajos en aquellos puntos en los que la reconstrucción 3D no muestra viñedo y los valores de volumen más altos generalmente se presentan en las zonas más frondosas.

Conclusiones

El artículo describe los aspectos principales de un sistema de inspección diseñado y desarrollado para explorar cultivos de forma autónoma. El sistema de inspección se compone de una plataforma móvil basada en un vehículo eléctrico comercial que integra un conjunto de sensores, entre ellos un sensor RGB-D, para obtener información en dos tipos de escenarios: cultivos anuales (maíz, cereales, etc.) y cultivos plurianuales (huertos, viñedos, etc.). Los muestreos realizados hasta la fecha en cultivos reales, principalmente viñedos, han mostrado la operación adecuada del sistema de adquisición de información en campo así como los buenos resultados en la reconstrucción 3D automática de viñedos y la generación de mapas de distribución de volúmenes. Se puede concluir que la tecnología presentada en este documento es particularmente interesante para el desarrollo de sistemas de monitorización de cultivos, siendo una propuesta complementaria, y en algunos casos alternativa, a los sistemas aéreos y/o satelitales.

Agradecimientos

Trabajo financiado por el Plan Estatal (AGL2014-52465-C4-3-R). Karla Cantuña agradece la comisión de servicios con remuneración otorgada por la Universidad Técnica de Cotopaxi (Ecuador). Agradecemos: 1) a Codorniu SA las facilidades en los muestreos; 2) a Jordi Recasens y su equipo (Grupo de investigación de Malherbología y Ecología Vegetal de la Universidat de Lleida) su inestimable ayuda en las pruebas de campo; y 3) a Damián Rodríguez su apoyo técnico continuo.

Bibliografía

- Alphashape3d package 2016 https://cran.r-project.org/web/packages/alphashape3d/index.html

- Bechar, A., Vigneault, C. (2016). Agricultural robots for field operations: Concepts and components. Biosystems Engineering, 149, 94-111.

- Bengochea-Guevara, J M., Conesa-Muñoz, J., Andújar, D., Ribeiro, A., 2016. Merge fuzzy visual servoing and GPS-based planning to obtain a proper navigation behavior for a small crop-inspection robot. Sensors, 16(3), 276.

- Bengochea-Guevara, J. M., Andújar, D., Sanchez-Sardana, F. L., Cantuña, K., Ribeiro, A. 2017. A Low-Cost Approach to Automatically Obtain Accurate 3D Models of Woody Crops. Sensors, 18(1), 30.

- Chen, Y., & Medioni, G., 1992. Object modelling by registration of multiple range images. Image and Vision Computing 10(3), 145–155.

- Conesa-Muñoz J, Bengochea-Guevara JM, Andújar D and Ribeiro A 2016. Route planning for agricultural tasks: a general approach for fleets of autonomous vehicles in site-specific herbicide applications. Computers and Electronics in Agriculture. 127 204-220.

- Edelsbrunner, H., & Mücke, E. P., 1994. Three-dimensional alpha shapes. ACM Transactions on Graphics, 13(1), 43-72.

- Niessner, M., Zollhöfer, M., Izadi, S., & Stamminger, M. 2013. Real-time 3D reconstruction at scale using voxel hashing. ACM Transactions on Graphics (TOG), 32(6), 169.

- Newcombe, R. A., Izadi, S., Hilliges, O., Molyneaux, D., Kim, D., Davison, A. J., Kohli, P., Shotton, J., Hodges, S., & Fitzgibbon, A., 2011. KinectFusion: Real-time dense surface mapping and tracking. In Mixed and augmented reality (ISMAR), 10th IEEE international symposium on (pp. 127-136).

- Zadeh, L. A., 1965. Fuzzy sets. Information and Control, 8(3), 338–353