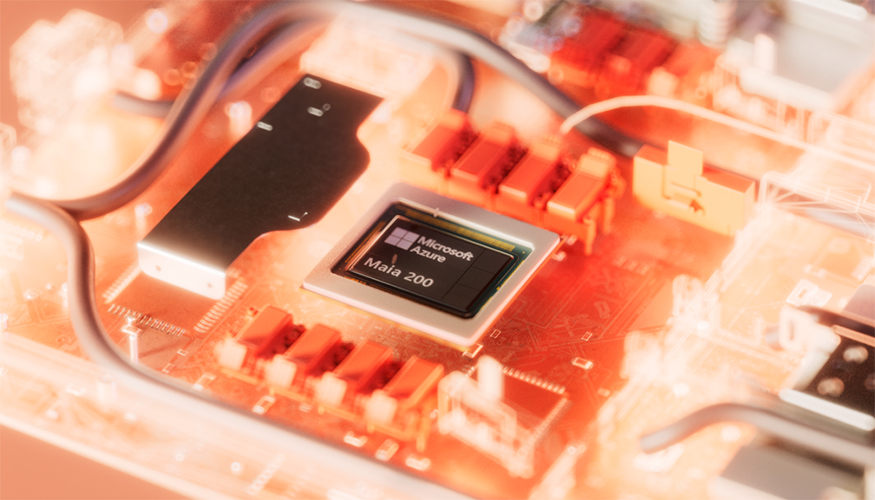

Microsoft presenta Maia 200, su chip acelerador de IA orientado al razonamiento avanzado

Microsoft ha anunciado el lanzamiento de Maia 200, su nuevo chip acelerador de Inteligencia Artificial de nueva generación, diseñado para responder a las crecientes exigencias de la denominada era de la IA del razonamiento. La compañía destaca tanto su elevado rendimiento como las ventajas de coste que aporta frente a otras alternativas del mercado.

Maia 200 ofrece más de 10 PFLOPS en precisión de 4 bits (FP4) y alrededor de 5 PFLOPS en 8 bits (FP8). En la práctica, un nodo Maia 200 es capaz de ejecutar los modelos de IA más grandes disponibles actualmente, con margen suficiente para soportar modelos de mayor tamaño en el futuro.

Según los datos facilitados por Microsoft, el nuevo chip proporciona hasta tres veces más rendimiento FP4 que el Amazon Trainium de tercera generación y supera en rendimiento FP8 al TPU de séptima generación de Google, lo que lo sitúa entre las opciones más avanzadas del mercado para cargas de trabajo de IA intensivas.

El chip Maia 200 proporciona más de 10 PFLOPS en precisión de 4 bits (FP4) y alrededor de 5 PFLOPS en 8 bits (FP8).

Despliegue en centros de datos y uso en servicios clave

Maia ya se encuentra desplegado en la región de centros de datos 'US Central' de Microsoft. Los primeros sistemas basados en Maia 200 están impulsando nuevos modelos desarrollados por el equipo de Microsoft Superintelligence, además de acelerar proyectos de Microsoft Foundry y dar soporte a servicios como Microsoft Copilot.

Un modelo integrado como ventaja competitiva

Microsoft subraya que su enfoque integrado —que combina hardware, modelos y aplicaciones— constituye una ventaja competitiva diferencial. Al operar algunas de las cargas de trabajo de IA más exigentes a nivel global, la compañía puede optimizar de forma conjunta el diseño de los chips, el desarrollo de modelos y su aplicación en servicios reales, alineando rendimiento, eficiencia y escalabilidad.